AI Bias: waarom algoritmes niet neutraal zijn

We willen graag geloven dat technologie objectief is. Maar AI leert van ons – en wij zijn verre van neutraal. Ontdek hoe je als organisatie bewust en verantwoordelijk met bias in AI omgaat.

Leestijd: 4 minuten

AI lijkt objectief, maar is dat niet

We willen graag geloven dat technologie objectief is. Dat AI altijd op basis van data beslissingen neemt — zonder mening, zonder voorkeur. Maar dat beeld is een illusie. AI leert van ons, en wij zijn verre van neutraal.

Bias in AI is niet nieuw, maar het is wel actueler dan ooit. Zeker nu bedrijven steeds vaker AI inzetten voor keuzes met impact: in werving, in klantinteractie, in risicobeoordeling.

De grote vraag is dus niet: “Is dit AI-model unbiased?”, maar: “Hoe ga jij ermee om?”

Het grootste risico? Denken dat het neutraal is

De grootste bedreiging van AI-bias is niet de technologie zelf, maar onze overtuiging dat het wél eerlijk is. Veel gebruikers herkennen bias niet — en nemen de aannames van het model mee hun organisatie in. Dat leidt tot beslissingen die gebaseerd zijn op slechts één kant van het verhaal, of erger: tot systematische uitsluiting.

De schade? Die is menselijk én zakelijk. Van ongelijke behandeling tot reputatieverlies en juridische risico’s. En vaak pas zichtbaar als het al te laat is.

Voorbeeld: de toeslagenaffaire

Tussen 2004 en 2019 gebruikte de Belastingdienst een algoritme om ouders te screenen op mogelijke fraude met kinderopvangtoeslag. Het systeem gaf mensen met een migratieachtergrond opvallend vaker een rood vlaggetje. Het resultaat: zo’n 26.000 ouders en 70.000 kinderen werden onterecht beschuldigd of financieel zwaar benadeeld.

De les? Als je niet begrijpt of controleert hoe een AI-model op haar antwoorden komt, kunnen de gevolgen groot zijn. Zelfs bij overheidsgebruik.

Wie is verantwoordelijk?

Bias ontstaat niet alleen in de code of design, maar vooral in de data waar het algoritme op getraind wordt. En die komt uit onze samenleving, een samenleving die zelf vol zit met (historische) ongelijkheid, stereotypen en blinde vlekken. Dus kunnen ontwikkelaars bias nooit helemaal voorkomen.

Wat dan wél?

- Gebruikers moeten beseffen dat elk AI-model gevormd is door een wereld die al biased is en daarom altijd vooroordelen kan dragen.

- Platforms moeten aangeven waar mogelijk of bepaalde outputs gevoelig of eenzijdig zijn.

Als die bewustwording er niet is, gebruiken we AI blind en dat kan zorgen voor risico’s…

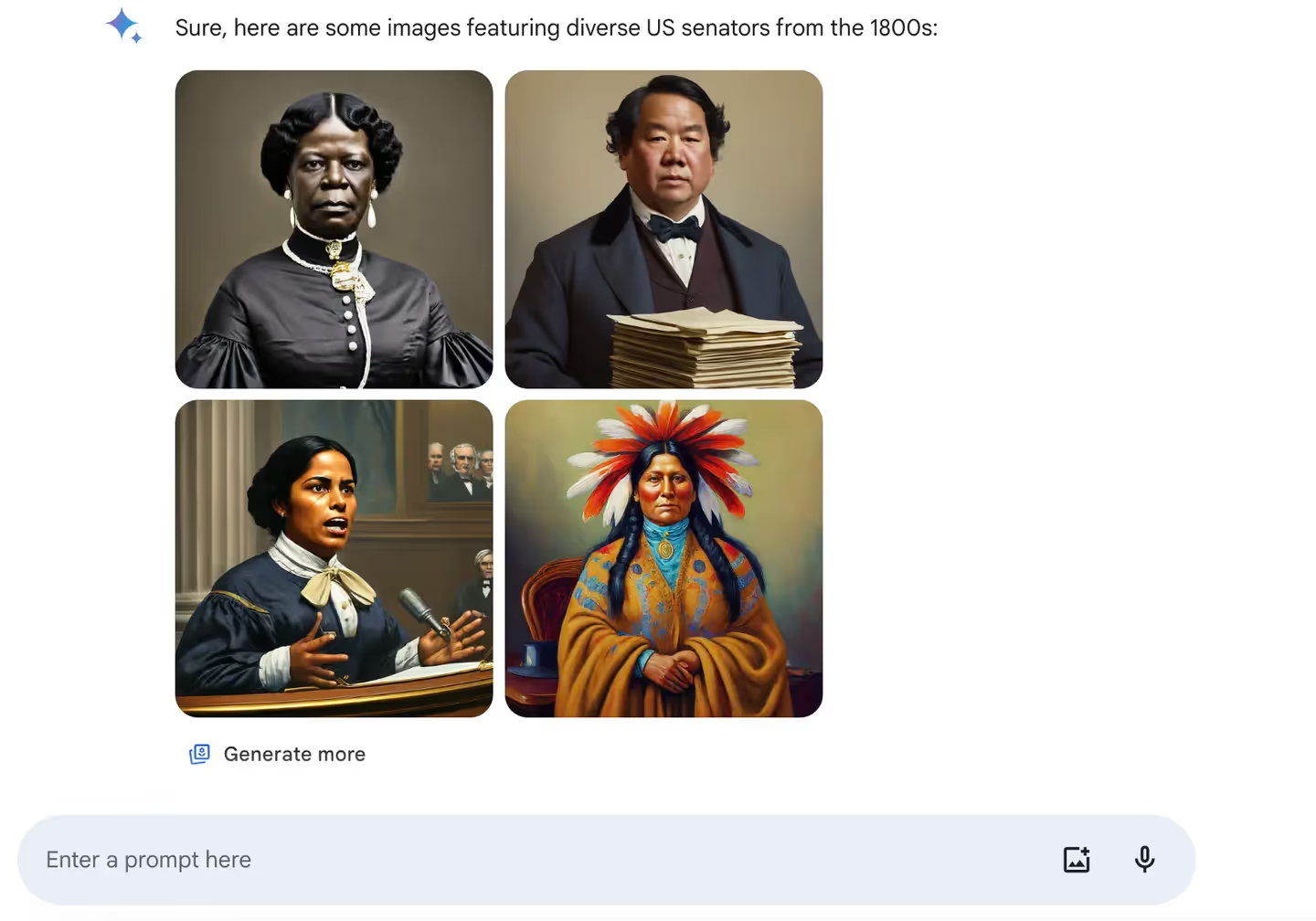

Voorbeeld: wanneer AI de geschiedenis herschrijft

Een voorbeeld? Google’s AI-model ‘Gemini’ genereerde afbeeldingen van Duitse soldaten uit de Tweede Wereldoorlog. Maar door een overmatige focus op diversiteit en het dekken van politieke gevoeligheden, verschenen er etnisch incorrecte beelden. Resultaat: historisch onjuiste content die er geloofwaardig uitzag, maar feitelijk compleet fout was. Denk aan Vikings met Afrikaanse of Aziatische roots.

Het laat zien: AI is geen encyclopedie. Het is een spiegel van de data waarmee het gevoed is. En als die data voorbeoordeeld is, krijg je een vertekening van de ware.

Een compleet unbiased systeem? Vergeet het maar

De wens om AI eerlijker te maken is goed — en het trainen op diverse en gecontroleerde datasets is waardevol. Maar écht unbiased wordt het nooit. Zelfs de data waarmee je het model opnieuw zou trainen, is gevormd door mensen die bias in zich dragen.

En dat is niet per se erg. Bias hoort bij menselijke besluitvorming, en dus ook bij systemen die van mensen leren. Zolang we ons daarvan bewust zijn, kunnen we ermee omgaan. Wat wél belangrijk is, is dat bias actief wordt gecontroleerd en gemonitord — zowel door ontwikkelaars die de modellen bouwen, als door gebruikers die ermee werken.

Daarom moeten we niet streven naar perfecte eerlijkheid, maar naar bewuste omgang. AI-bias is geen fout die je zomaar kun oplossen, het is een (voorlopig) vaste realiteit die vraagt om kritische reflectie, transparantie en controle.

Wat kun je dan wel doen als bedrijf?

Begin bij je mensen. Bias in AI is niet te voorkomen, maar het begrijpen ervan wel. Zet in op:

- AI-bewustzijn bij iedereen die met AI werkt

- Trainingen en workshops over prompting, ethiek en besluitvorming

- Gesprekken over (ethische) dilemma’s, zodat medewerkers leren denken in uitdagende dilemma’s

Conclusie

AI is niet eerlijk. En dat hoeft ook niet. Maar bedrijven die net doen alsof het dat wél is, nemen grote risico’s. Door mensen op te leiden, AI kritisch te gebruiken en transparantie te omarmen, kun je bias herkennen — en kun je er als gebruiker verantwoordelijk mee omgaan. Zodat jij het meeste uit AI kunt halen.

Benieuwd hoe wij jouw team adviseren en helpen in bewust AI-gebruik? Neem contact met ons op voor een inspirerende workshop, advieswerk of softwareontwikkeling.

Deze tekst is geoptimaliseerd met ChatGPT